首页科学前沿

研究发现:机器人是实际上是道德僵尸

2014-09-29 09:38 浏览 评论

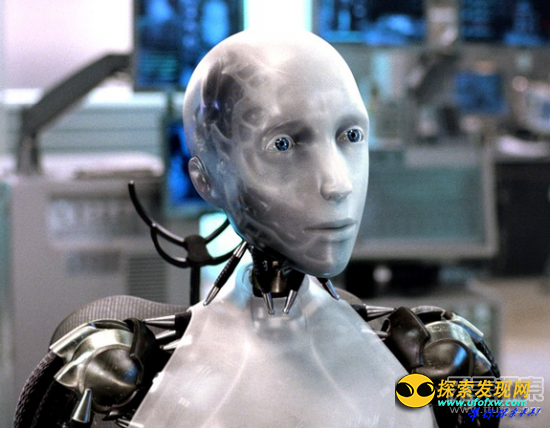

英国媒体网站9月14日称,机器人能分辨对错吗?想让机器人、自动驾驶汽车和军用机械有道德观念实在是太难了。

我们能否教育机器人做个“好人”?带着这个想法,英国布里斯托尔机器人实验室的机器人专家艾伦·温菲尔德为机器人制造了一个道德陷阱,而接下来,机器人的反应则令人震惊。

机器人必须防止人类受伤害

在一个实验中,温菲尔德和他的同事为机器人设定了一个程序:阻止其他拟人机器人掉进洞里。这是艾萨克·阿西莫夫(美国著名的科幻小说家)提出的机器人三大定律之一——机器人必须防止人类受伤害——的简版。

一开始,机器人还能顺利完成任务:当拟人机器人向洞口移动时,机器人会冲上前去将其推开,防止其掉到洞里。

当拟人机器人向洞口移动时,机器人会冲上前去将其推开,防止其掉到洞里

随后,研究小组又添加了一个拟人机器人,两个拟人机器人同时向洞口移动,救人机器人则要被迫做出选择。

有时,它成功地救了一个“人”,而另一个掉进了洞里;有几次,它甚至想要两个都救;然而在33次测试中,有14次因为在救哪一个的问题上不知所措而浪费了时间,以至于两个“人”都掉进了洞里。

研究人员于9月2日在英国伯明翰召开的“迈向自主机器人系统”会议上向世人展示了他们的实验。

相关阅读

-

西班牙科学家研出舔食即变色冰激凌

-

科学家研发最黑材料 吸收所有可见光

-

专家欲研发机器人牧羊犬 狗狗要失业

-

科学家利用磁光捕获技术打造最冷分子

-

纽约出现"末日"场景 天降冰雹暴雨肆虐闪电

-

最新研究指出泰坦尼克号沉没不可避免

精选推荐

精彩推荐